RAISR: Google spart Bandbreite durch Bilder-Upsampling

Maschinelles Lernen hilft, aus Bildern mit geringer Auflösung qualitativ gute Bilder in höherer Auflösung zu erzeugen. Die Technologie ist auf Smartphones in Echtzeit ausführbar und spart rund ein Drittel an Bandbreite. Sie kommt wöchentlich bereits bei einer Milliarde Bildern auf Google+ zum Einsatz.

Google hat mit maschinellem Lernen eine Technologie entwickelt, die aus Bildern mit niedriger Auflösung solche von weit besserer Qualität erzeugt, die sich auch in hoher Auflösung darstellen lassen. RAISR soll insbesondere Smartphone-Nutzern, die auf eine mobile Datenverbindung angewiesen sind, eventuell kostspieliges Übertragungsvolumen ersparen.

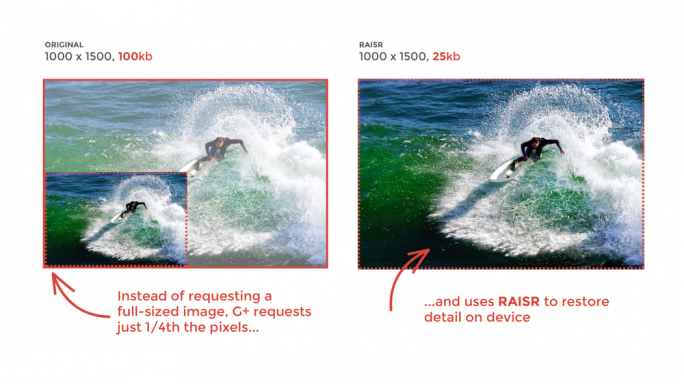

RAISR steht für “Rapid and Accurate Image Super Resolution”. Es baut auf dem schon lange bekannten Upsampling auf, das größere Bilder mit wesentlich mehr Pixeln aus einem Bild mit geringer Qualität erzeugt. Da diese Methode um der höheren Geschwindigkeit wegen meist mit linearen Filtern arbeitet, fallen die Ergebnisse jedoch eher unscharf aus.

Die Google-Forscher setzten auf maschinelles Lernen, um das Upsampling zu verbessern. Für das Training kamen Bilderpaare – jeweils eines mit niedriger und eines mit hoher Qualität – zum Einsatz. Damit sollten leistungsfähigere Filter gefunden werden, mit denen sich Details wiederherstellen lassen, die in ihrer Qualität dem Original vergleichbar sind. Bei der erstmaligen Vorstellung im November versicherten die Forscher, dass RAISR nicht nur hervorragende Ergebnisse erzielt, sondern das auch noch mit rund zehnfacher bis hundertfacher Geschwindigkeit. Das wiederum sollte den Einsatz der Technologie auf einem üblichen Mobilgerät in Echtzeit erlauben.

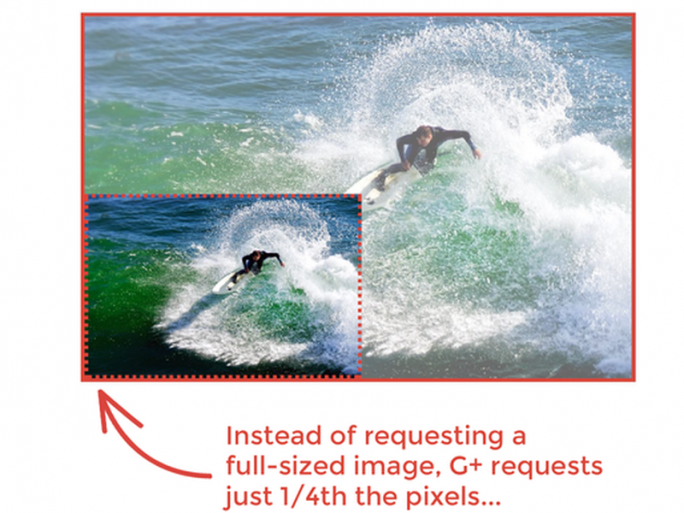

Zuerst wandte Google RAISR in seiner iOS-App Motion Stills an und begann danach, sie bei Fotos auf Google+ anzuwenden. “Indem wir RAISR für die Darstellung von großen Bildern auf Google+ nutzten, kamen wir bei diesen Bildern mit bis zu 75 Prozent weniger Bandbreite aus”, berichtet Produktmanager John Nack in einem Blogeintrag. Demnach musste von Googles Servern nur ein Bruchteil der Pixel angefordert werden, um ein Bild in vergleichbar guter Qualität darzustellen.

“Während wir erst damit begonnen haben, das auf hochauflösende Bilder anzuwenden, wenn sie auf ausgewählten Android-Geräten ankommen”, führt Nack weiter aus, “setzen wir RAISR bereits auf mehr als eine Milliarde Bildern je Woche ein, was die insgesamt benötigte Bandbreite dieser Nutzer um etwa ein Drittel verringert. In den kommenden Wochen wollen wir diese Technologie breiter einführen – und sind gespannt, was wir damit weiter an Zeit und Daten einsparen können.”

[mit Material von Liam Tung, ZDNet.com]