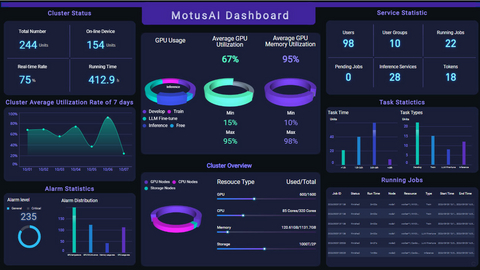

KAYTUS, ein führender Anbieter von End-to-End-KI- und Flüssigkeitskühlsystemen, gab heute auf der ISC High Performance 2025 die Freigabe der neuesten Version seiner MotusAI KI-DevOps-Plattform bekannt. Die verbesserte MotusAI-Plattform bietet erhebliche Verbesserungen bei der Inferenzleistung großer Modelle und ist umfassend kompatibel mit diversen Open-Source-Tools, die den gesamten Lebenszyklus großer Modelle abdecken. Die Plattform wurde für eine einheitliche und dynamische Ressourcenplanung entwickelt und verbessert die Ressourcennutzung und betriebliche Effizienz bei der Entwicklung und Bereitstellung groß angelegter KI-Modelle erheblich. Diese neueste Version von MotusAI wird die KI-Einführung weiter beschleunigen und Geschäftsinnovationen in wichtigen Sektoren wie Bildung, Finanzen, Energie, Automobil und Fertigung vorantreiben.

Diese Pressemitteilung enthält multimediale Inhalte. Die vollständige Mitteilung hier ansehen: https://www.businesswire.com/news/home/20250612825390/de/

Da große KI-Modelle zunehmend in reale Anwendungen integriert werden, setzen Unternehmen sie in großem Maßstab ein, um in vielen verschiedenen Sektoren einen greifbaren Mehrwert zu generieren. Dennoch stehen viele Unternehmen bei der Einführung von KI weiterhin vor großen Herausforderungen, darunter lange Bereitstellungszyklen, strenge Stabilitätsanforderungen, fragmentiertes Open-Source-Tool-Management und geringe Auslastung der Rechenressourcen. Um diese Schwachstellen zu beheben, hat KAYTUS die neueste Version seiner MotusAI AI DevOps-Plattform eingeführt, die speziell dafür entwickelt wurde, die KI-Bereitstellung zu rationalisieren, die Systemstabilität zu verbessern und die Effizienz der KI-Infrastruktur für den Betrieb großer Modelle zu optimieren.

Verbesserte Inferenzleistung zur Gewährleistung der Servicequalität

Die Bereitstellung von KI-Inferenzdiensten ist ein komplexes Unterfangen, das die Bereitstellung, Verwaltung und kontinuierliche Integritätsüberwachung der Dienste umfasst. Diese Aufgaben erfordern strenge Standards in der Modell- und Service-Governance, Leistungsoptimierung über Beschleunigungsframeworks und langfristige Servicestabilität. All dies erfordert in der Regel erhebliche Investitionen in Personal, Zeit und technisches Know-how.

Das aktualisierte MotusAI bietet robuste Funktionen für die Bereitstellung großer Modelle, die Transparenz und Leistung perfekt aufeinander abstimmen. Durch die Integration optimierter Frameworks wie SGLang und vLLM gewährleistet MotusAI leistungsstarke, verteilte Inferenzdienste, die Unternehmen schnell und zuverlässig bereitstellen können. MotusAI wurde zur Unterstützung von Modellen mit umfangreichen Parametersätzen entwickelt und nutzt intelligente Ressourcen- und Netzwerkaffinitätsplanung, um die Zeit bis zum Start zu verkürzen und gleichzeitig die Hardwareauslastung zu maximieren. Die integrierten Überwachungsfunktionen decken den gesamten Stack ab – von Hardware und Plattformen bis hin zu Pods und Diensten – und bieten eine automatische Fehlerdiagnose und schnelle Dienstwiederherstellung. MotusAI unterstützt außerdem die dynamische Skalierung von Inferenz-Workloads basierend auf Echtzeit-Nutzung und Ressourcenüberwachung und sorgt so für einen stabileren Service.

Umfassende Unterstützung von Tools zur Beschleunigung der KI-Einführung

Mit der rasanten Weiterentwicklung von KI-Modelltechnologien nimmt auch die Komplexität des unterstützenden Ökosystems von Entwicklungstools zu. Entwickler benötigen eine optimierte, universelle Plattform, um diese Tools effizient auswählen, bereitstellen und betreiben zu können.

Die aktualisierte MotusAI bietet umfassende Unterstützung für eine Vielzahl führender Open-Source-Tools und ermöglicht es Unternehmensanwendern, ihre Modellentwicklungsumgebungen nach Bedarf zu konfigurieren und zu verwalten. Mit integrierten Tools wie LabelStudio beschleunigt MotusAI die Datenannotation und -synchronisierung über verschiedene Kategorien hinweg, verbessert die Effizienz der Datenverarbeitung und beschleunigt die Modellentwicklungszyklen. MotusAI bietet außerdem eine integrierte Toolchain für den gesamten Lebenszyklus von KI-Modellen. Dazu gehören LabelStudio und OpenRefine für die Datenannotation und -verwaltung, LLaMA-Factory für die Feinabstimmung großer Modelle, Dify und Confluence für die Entwicklung großer Modellanwendungen und Stable Diffusion für die Text-zu-Bild-Generierung. Zusammen ermöglichen diese Tools den Anwendern eine schnelle Einführung großer Modelle und steigern die Entwicklungsproduktivität in hohem Maße.

Hybride Trainings-Inferenz-Planung auf demselben Knoten zur Maximierung der Ressourceneffizienz

Die effiziente Nutzung von Rechenressourcen behält für KI-Startups und kleine bis mittelgroße Unternehmen in den frühen Phasen der KI-Einführung eine hohe Priorität. Herkömmliche KI-Cluster weisen Rechenknoten in der Regel separat für Trainings- und Inferenzaufgaben zu, was die Flexibilität und Effizienz der Ressourcenplanung für beide Arten von Workload einschränkt.

Das aktualisierte MotusAI überwindet herkömmliche Einschränkungen, indem es eine hybride Planung von Trainings- und Inferenz-Workloads auf einem einzigen Knoten ermöglicht und so eine nahtlose Integration und dynamische Orchestrierung verschiedener Aufgabentypen ermöglicht. MotusAI verfügt über fortschrittliche GPU-Scheduling-Funktionen und unterstützt die bedarfsgerechte Zuweisung von Ressourcen, sodass Benutzer die GPU-Ressourcen je nach Arbeitslast der einzelnen Aufgaben effizient verteilen können. MotusAI bietet außerdem eine mehrdimensionale GPU-Planung, einschließlich feinkörniger Partitionierung und Unterstützung für Multi-Instance-GPU (MIG), und deckt damit eine Vielzahl von Anwendungsfällen in den Bereichen Modellentwicklung, Debugging und Inferenz ab.

Der verbesserte Scheduler von MotusAI übertrifft Community-basierte Versionen deutlich und bietet eine 5-fache Erhöhung des Aufgabendurchsatzes sowie eine 5-fache Verringerung der Latenz bei groß angelegten POD-Bereitstellungen. Er ermöglicht einen schnellen Start und die Bereitstellung der Umgebung für Hunderte von PODs und unterstützt gleichzeitig die dynamische Skalierung der Arbeitslast und die Tidal-Planung sowohl für das Training als auch für die Inferenz. Diese Funktionen ermöglichen eine nahtlose Aufgabenkoordination in einer Vielzahl realer KI-Szenarien.

Über KAYTUS

KAYTUS ist ein führender Anbieter von End-to-End-KI- und Flüssigkeitskühlungslösungen. Das Unternehmen bietet eine Vielzahl innovativer, offener und umweltfreundlicher Produkte für Cloud-, KI-, Edge-Computing- und andere neu aufkommende Anwendungen. KAYTUS verfolgt einen kundenorientierten Ansatz und geht mit seinem anpassungsfähigen Geschäftsmodell flexibel und reaktionsschnell auf die Bedürfnisse der Benutzer ein. Erfahren Sie mehr unter KAYTUS.com und folgen Sie uns auf LinkedIn und X.

Die Ausgangssprache, in der der Originaltext veröffentlicht wird, ist die offizielle und autorisierte Version. Übersetzungen werden zur besseren Verständigung mitgeliefert. Nur die Sprachversion, die im Original veröffentlicht wurde, ist rechtsgültig. Gleichen Sie deshalb Übersetzungen mit der originalen Sprachversion der Veröffentlichung ab.

Originalversion auf businesswire.com ansehen: https://www.businesswire.com/news/home/20250612825390/de/